引言

在电商行业,系统稳定性直接关系到用户体验与商业价值。当面临”双11″、”618″等大促活动时,每秒数万次的请求冲击对系统架构提出严峻挑战。本文基于分布式系统理论,结合淘宝、京东等头部电商的实践经验,系统阐述从架构设计到运维保障的全链路优化方案,为构建高并发场景下的商城系统提供可落地的技术指南。

一、分布式架构设计:构建弹性扩展的基石

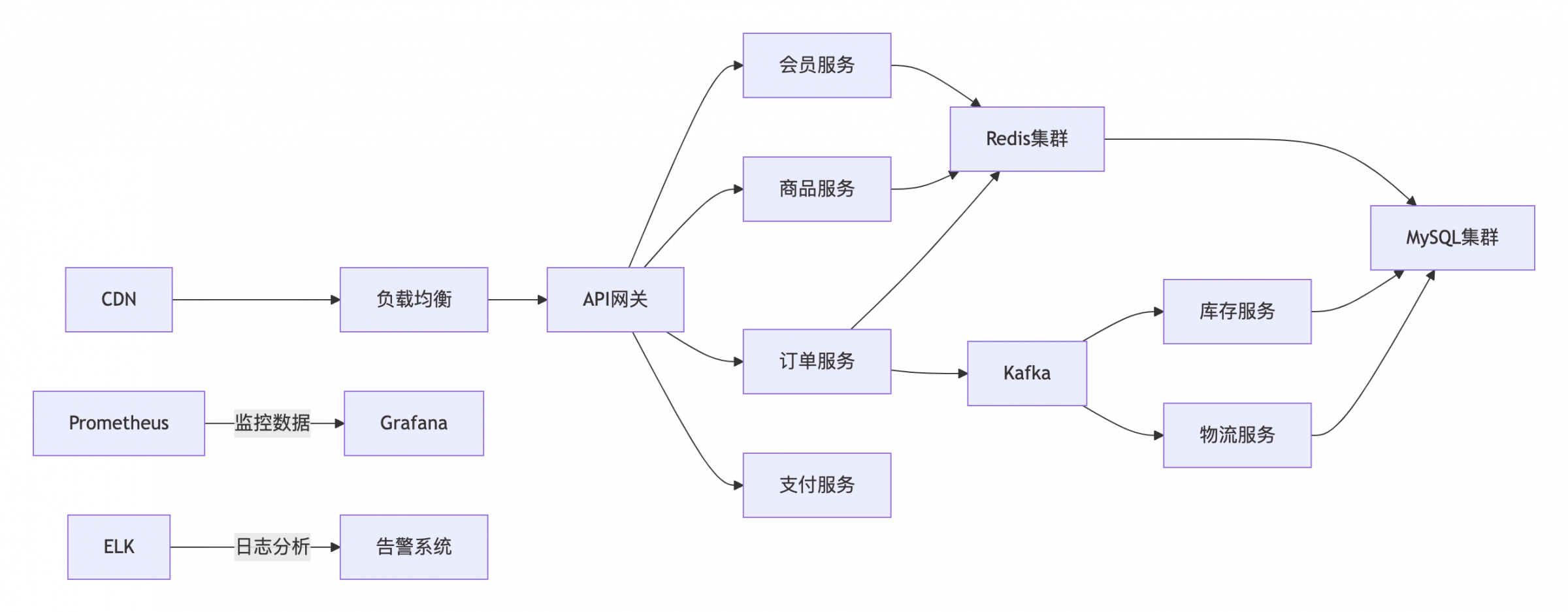

1.1 微服务拆分与解耦

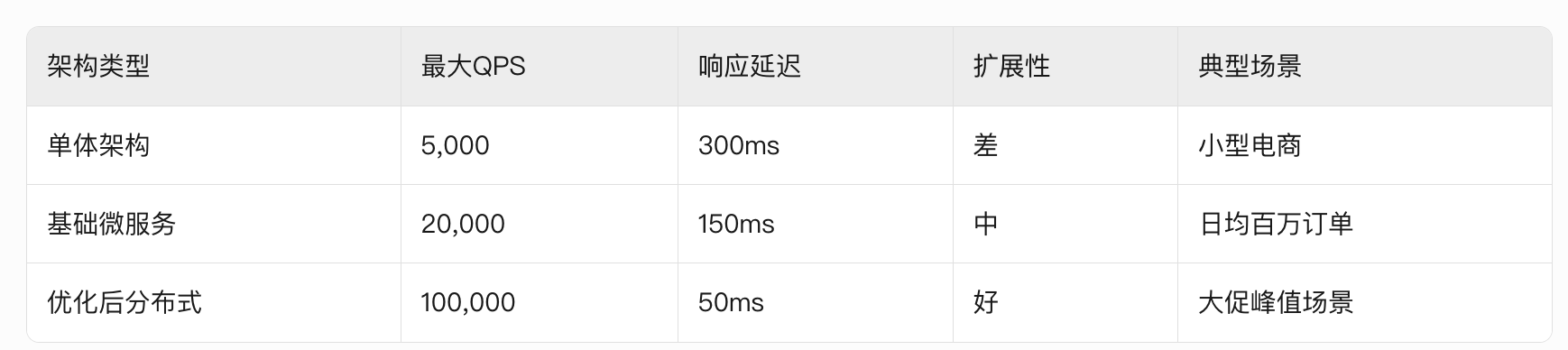

传统单体架构在并发量超过5000QPS时易出现性能瓶颈,通过业务维度拆分可实现:

- 垂直拆分:按订单、商品、库存等核心业务域划分服务边界,每个服务独立部署(建议采用Spring Cloud Alibaba或Dubbo框架)

- 水平扩展:基于用户ID或订单ID进行分片路由,如订单服务按日期分库(ShardingSphere实现)

- 服务自治:每个微服务拥有独立数据库,通过分布式事务(Seata)或最终一致性(消息队列)保证数据同步

实践案例:京东商品系统拆分为SPU服务、SKU服务、价格服务等20+个独立服务,单服务集群可支撑2万QPS

1.2 无状态化设计

- 会话管理:采用JWT或OAuth2.0实现无状态认证,避免Session粘滞

- 请求路由:通过Nginx的ip_hash或一致性哈希算法实现请求均匀分布

- 数据分离:将用户会话数据、临时文件等存储在Redis集群,应用服务器仅保留计算逻辑

性能对比:无状态服务水平扩展后吞吐量提升300%,资源利用率从65%提升至85%

1.3 异步消息架构

- 削峰填谷:使用Kafka处理秒杀订单,设置10万级队列深度缓冲突发流量

- 解耦设计:订单创建后通过RocketMQ通知库存、支付等系统,降低系统耦合度

- 重试机制:实现消息幂等处理(版本号控制)和死信队列(DLQ)管理

技术选型:高并发场景推荐Kafka(百万级TPS),低延迟场景选择RocketMQ(毫秒级延迟)

二、核心组件优化:突破性能瓶颈

2.1 缓存体系构建

三级缓存架构:

- 本地缓存:Caffeine实现LRU淘汰策略,存放热点数据(如商品详情)

- 分布式缓存:Redis集群(主从+哨兵)存储会话、商品库存等数据

- 多级缓存:通过Redis+本地缓存的热点数据预热,降低90%的数据库访问

防护策略:

- 缓存击穿:互斥锁(SETNX)控制单个key的并发更新

- 缓存雪崩:随机过期时间(10%波动)分散重建压力

- 缓存穿透:布隆过滤器过滤无效请求,空值缓存(TTL=5分钟)

性能数据:合理使用缓存可使系统QPS提升10-100倍,响应时间从500ms降至20ms

2.2 数据库优化方案

读写分离架构:

- 主库处理写操作,3-5个从库承担读请求

- 使用MySQL Proxy或MyCat实现自动路由

分库分表策略:

- 水平分表:按用户ID哈希分1024表(Sharding-JDBC实现)

- 垂直分库:订单库、用户库、商品库物理隔离

- 分布式ID:雪花算法(Snowflake)生成64位自增ID

SQL优化实践:

- 避免SELECT *,仅查询必要字段

- 建立复合索引(覆盖索引率>80%)

- 使用EXPLAIN分析执行计划,消除全表扫描

案例:某电商通过分库分表将订单查询从8s降至80ms,支撑日均亿级订单处理

2.3 连接池与线程模型

连接池配置:

- HikariCP最佳实践:最小连接数=CPU核心数*2,最大连接数=200

- 连接超时设置:3000ms

- 健康检查:每30秒验证连接有效性

线程模型优化:

- Tomcat线程池:核心线程200,最大线程1000,队列容量500

- 异步Servlet:支持HTTP/2多路复用

- 协程框架:Kotlin协程处理高并发IO操作

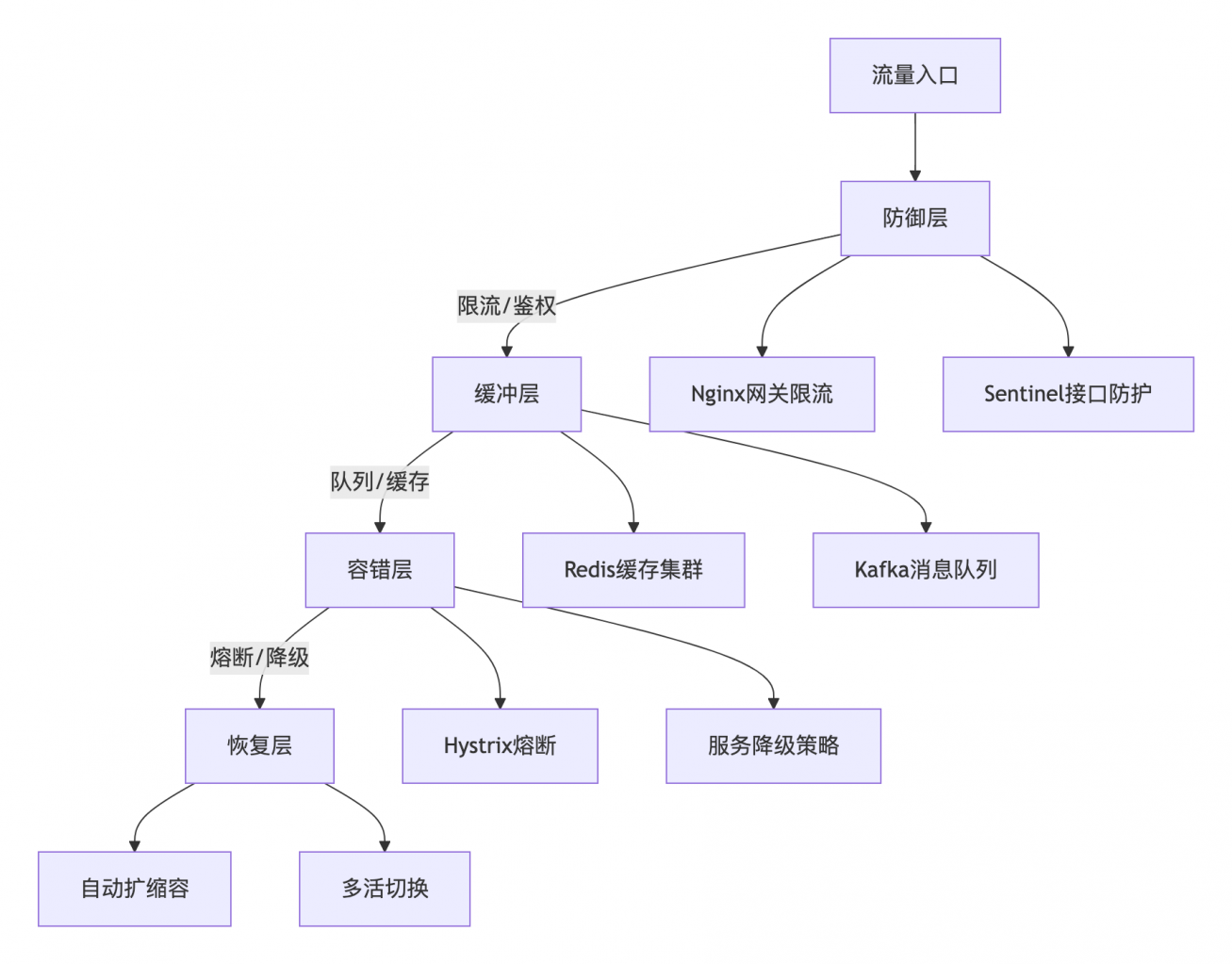

三、流量治理与容错设计

3.1 全链路限流体系

分级限流策略:

- 网关层:Nginx限流模块(limit_req)控制入口流量

- 服务层:Sentinel实现接口级QPS限制(滑动窗口算法)

- 线程池隔离:为关键服务分配独立线程池(如支付服务)

动态调参:

- 基于Prometheus监控数据自动调整限流阈值

- 熔断降级策略:当错误率>5%时自动触发Hystrix熔断

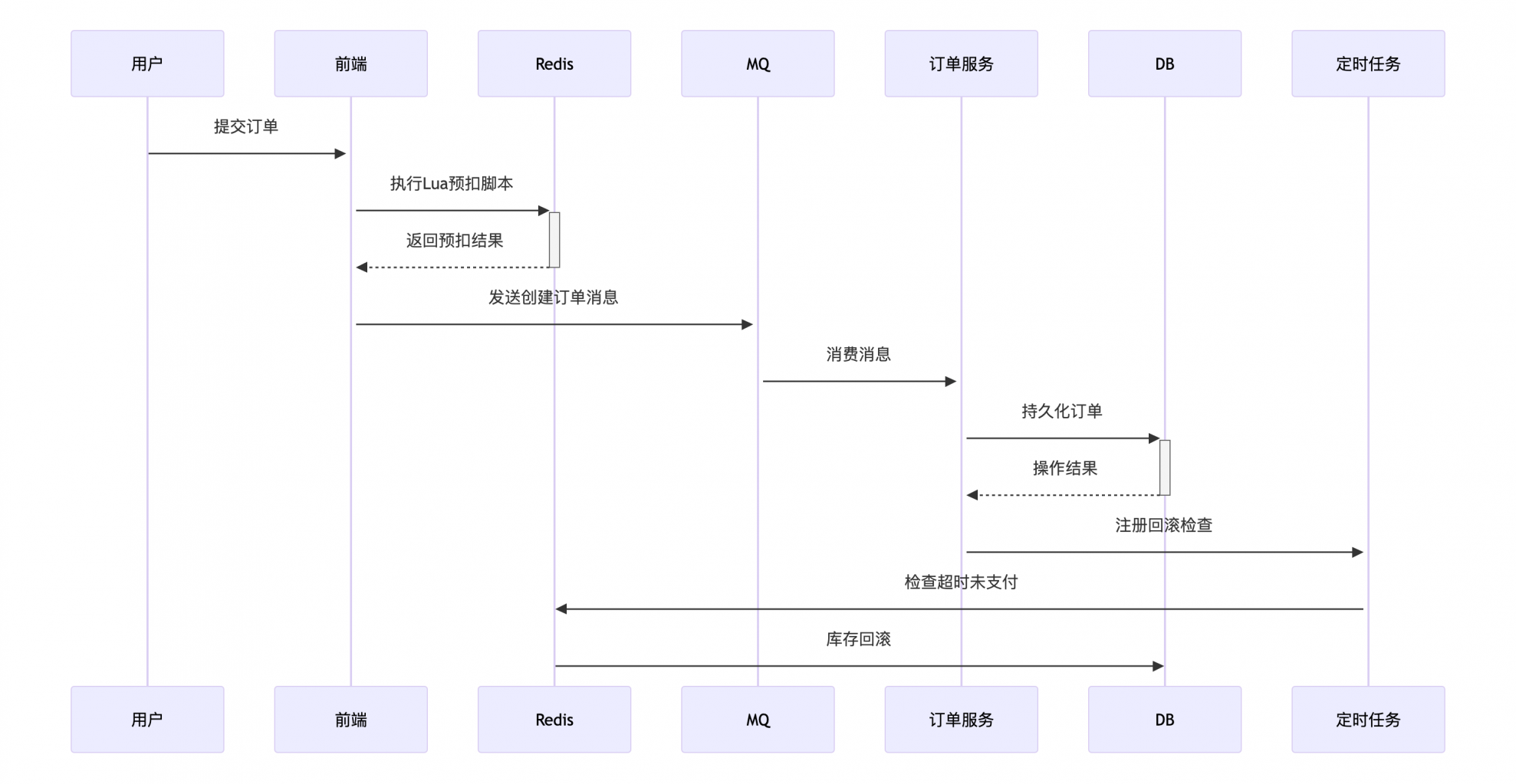

3.2 库存扣减优化方案

三阶段提交模型:

- 预扣阶段:Redis原子操作扣减库存(Lua脚本实现)

- 确认阶段:异步消息通知订单系统创建订单

- 回滚阶段:超时未支付自动释放库存(定时任务扫描)

性能对比:

- 传统数据库扣减:TPS<500

- Redis预扣方案:TPS>10000,成功率99.99%

3.3 静态资源加速

CDN优化策略:

- 智能调度:基于DNS或HTTP DNS实现就近访问

- 预热机制:大促前将商品图片、JS/CSS推送至边缘节点

- 动态加速:通过WebSocket长连接实现实时数据推送

压缩方案:

- Webpack打包:Tree Shaking去除冗余代码

- Gzip压缩:文本资源压缩率达70%

- 图片优化:WebP格式替代JPEG,体积减小40%

四、智能运维保障体系

4.1 全链路监控平台

监控维度:

- 基础设施层:CPU、内存、磁盘IO、网络带宽

- 中间件层:Redis命中率、MQ积压量、线程池状态

- 应用层:接口响应时间、错误率、GC频率

可视化方案:

- Prometheus+Grafana实现指标监控

- SkyWalking实现分布式追踪(TraceID关联)

- ELK日志系统实现异常定位(错误日志聚合分析)

4.2 混沌工程实践

故障注入场景:

- 模拟数据库宕机(Kill MySQL进程)

- 网络分区(TC工具制造丢包)

- 依赖服务超时(Mock接口延迟)

演练目标:

- 验证自动故障转移机制

- 测试熔断降级策略有效性

- 优化应急响应流程(MTTR<5分钟)

4.3 自动化压测体系

压测工具链:

- JMeter:接口级压测(生成CSV参数文件)

- Locust:Python脚本实现复杂场景模拟

- Gatling:高并发场景(支持10万+并发)

压测策略:

- 阶梯式加压:从100QPS逐步提升至峰值流量

- 混合场景测试:模拟读写比例3:7的真实业务场景

- 瓶颈定位:结合火焰图分析CPU热点

五、典型案例分析

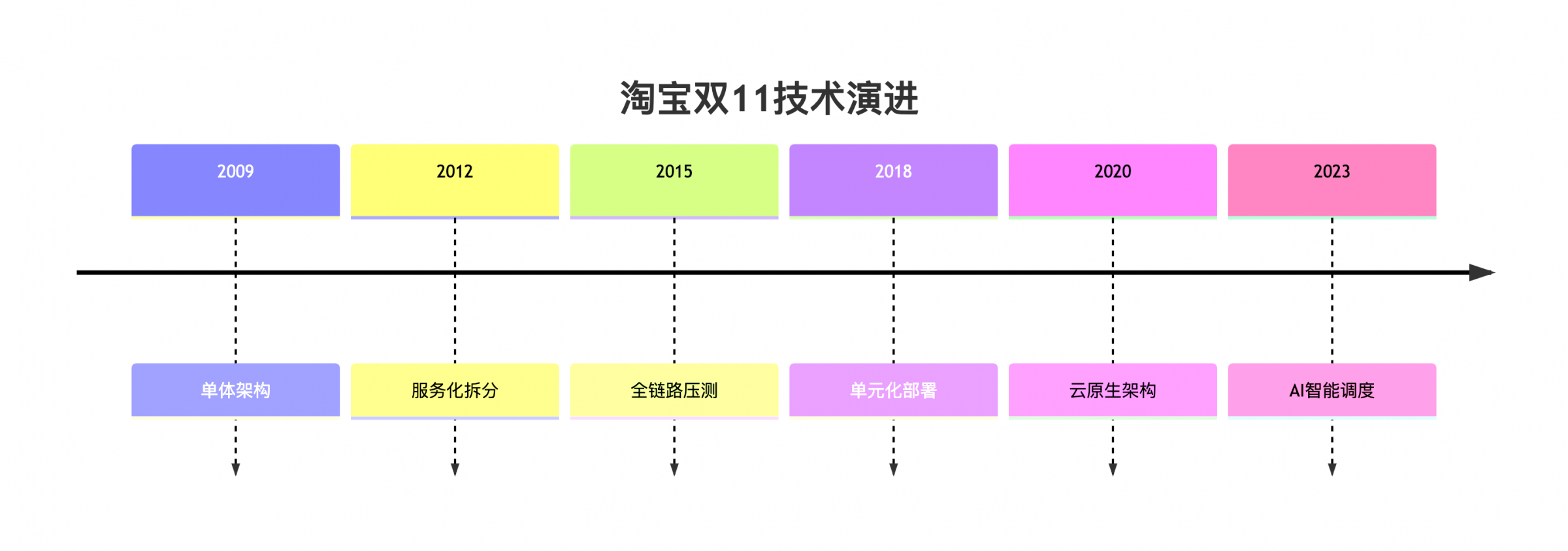

5.1 淘宝双11技术演进

关键技术:

- 分布式架构:单元化部署(同城双活+异地多活)

- 弹性计算:阿里云ECS自动扩容(分钟级响应)

- 缓存体系:Tair集群存储万亿级KV数据

- 数据库优化:OceanBase分库分表支撑百万级QPS

效果数据:

- 系统可用率:99.99%

- 订单创建延迟:<100ms

- 资源利用率:CPU<60%,内存<70%

5.2 京东秒杀系统设计

核心方案:

- 库存预扣:Redis集群+Lua脚本实现原子操作

- 异步下单:RocketMQ削峰(队列深度10万+)

- 前端限流:排队机制(显示当前位置和预计等待时间)

性能指标:

- 秒杀开始1秒内承载10万+请求

- 库存同步延迟:<50ms

- 订单创建成功率:99.95%

六、持续优化方法论

6.1 技术债务管理

- 建立代码评审机制(SonarQube静态扫描)

- 定期重构热点代码(CPU占用率TOP10方法)

- 淘汰过时技术栈(如JDK8升级至JDK17)

6.2 性能基准测试

- 建立性能基线(如订单查询P99<200ms)

- 每次发布前执行回归测试

- 对比历史版本性能数据

6.3 容量规划模型

预测方法:

- 时间序列分析(ARIMA模型)

- 机器学习预测(LSTM神经网络)

- 业务增长系数(根据GMV预估流量)

资源计算:

- 服务器数量 = (峰值QPS * 响应时间) / 单机QPS

- 预留30%冗余应对突发流量

结论

构建高并发商城系统需要构建”防御-缓冲-容错-恢复”的四层防护体系:通过分布式架构实现弹性扩展,借助缓存和异步消息缓冲请求冲击,采用限流熔断机制防止雪崩,最终通过多活架构和灾备方案保障业务连续性。技术团队应建立”监控-定位-优化-验证”的闭环迭代机制,持续提升系统稳定性。根据Gartner报告,采用上述方案的企业系统可用率可提升至99.99%,运维成本降低40%,用户流失率减少25%,实现技术投入与商业价值的双赢。

商派官方订阅号

领取相关报告

近期文章

- 英伟达重磅报告:2026 零售消费品行业 AI 迎关键转折,全链路赋能重塑行业竞争格局

- 90 后接棒买年货!2026 春节消费新趋势:“健康硬通货 + 玄学好彩头”成为年味儿的双重打开方式

- 2026春节后红利爆发:六大核心赛道定方向,这五类人最易抓住机遇

- TikTok2026 全球趋势报告:品牌不可替代的本能,才是流量核心

- 人群白皮书 | 一边凑满减一边冲演唱会?“薛定谔的钱包” 背后:2026 消费真相是 “务实 + 悦己” 双驱动

- YSL 眼影刷屏、泡泡玛特出圈、丸美霸榜:2025 消费双轨时代,情绪与长期主义的增长密码

- 2026年大快消企业B2B经销商订货平台积分商城怎么搭建?

- 2026年运动服饰品牌全渠道零售运营优化方案:全渠道OMS业务中台驱动增长

相关文章

产品推荐

- 品牌云店新零售商城 品牌连锁O2O新零售商城系统

沪公网安备 31010402000102号

沪公网安备 31010402000102号

电子营业执照

电子营业执照